Apa itu token pada AI bagaimana cara menghitungnya dan 1 token itu berapa kalimat sih?

Model bahasa besar seperti yang dikembangkan oleh OpenAI, memproses teks bukan sebagai kumpulan kata atau kalimat secara langsung, tetapi melalui unit-unit kecil yang disebut token. Token adalah potongan teks yang bisa berupa satu huruf, suku kata, kata utuh, atau bahkan tanda baca. Token-token ini merupakan urutan karakter yang sering muncul dalam kumpulan data teks yang digunakan untuk melatih model.

Selama proses pelatihan, model belajar memahami pola dan hubungan statistik antar token dalam berbagai konteks. Dengan kemampuan ini, model menjadi sangat mahir dalam memprediksi token selanjutnya dalam sebuah urutan — yang merupakan dasar dari bagaimana model ini bisa menulis, menjawab pertanyaan, dan menyusun teks yang relevan.

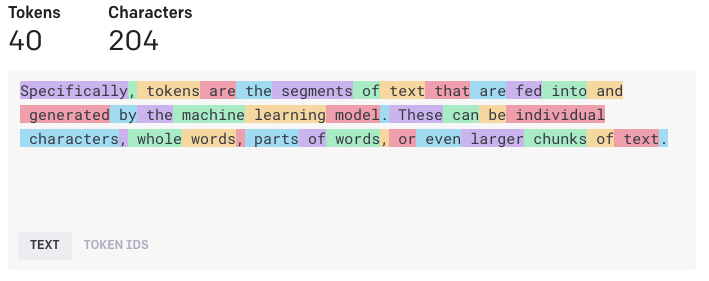

OpenAI menyediakan alat bantu (tool) yang dapat digunakan untuk melihat bagaimana sebuah potongan teks akan dipecah menjadi token oleh model bahasa. Selain itu, alat ini juga menunjukkan total jumlah token dalam teks tersebut, yang berguna untuk memahami seberapa panjang suatu input bagi model — karena model memiliki batas maksimum jumlah token yang bisa diproses dalam satu kali pemanggilan.

Aturan Praktis dalam Tokenisasi

Sebagai aturan praktis, satu token umumnya setara dengan sekitar 4 karakter teks dalam bahasa Inggris yang umum digunakan. Ini berarti, dalam rata-rata, satu token mencakup sekitar tiga per empat (¾) dari sebuah kata. Dengan kata lain, 100 token kurang lebih setara dengan 75 kata.

Penting untuk dicatat bahwa panjang token bisa sangat bervariasi tergantung pada bahasa, struktur kata, dan jenis teks. Misalnya, kata-kata panjang atau istilah teknis bisa dipecah menjadi beberapa token, sedangkan kata-kata pendek seperti "a" atau "the" hanya terdiri dari satu token.

Perbandingan dan efisien Tokens GPT-4o & GPT-4o mini, GPT-3.5 & GPT-4, GPT-3 (Legacy)

? Kalimat Input:

"aku makan pisang"

(Total karakter termasuk spasi = 16)

? Hasil Tokenisasi oleh Berbagai Model:

|

Model |

Jumlah Token |

Jumlah Karakter |

|

GPT-4o & GPT-4o mini |

4 tokens |

16 karakter |

|

GPT-3.5 & GPT-4 |

5 tokens |

16 karakter |

|

GPT-3 (Legacy) |

7 tokens |

16 karakter |

? Analisis Lengkap:

1. Karakter Tetap = 16

Semua model sepakat bahwa kalimat ini memiliki 16 karakter, yang terdiri dari:

- "aku" = 3 huruf

- spasi = 1

- "makan" = 5 huruf

- spasi = 1

- "pisang" = 6 huruf

→ Total = 3 + 1 + 5 + 1 + 6 = 16 karakter

2. Perbedaan Jumlah Token

Setiap model menggunakan tokenizer yang berbeda, yaitu cara mereka memecah teks menjadi potongan-potongan kecil (token) untuk diproses.

✅ GPT-4o & GPT-4o mini (4 tokens)

Model ini menggunakan tokenizer yang lebih canggih dan efisien. Ia mampu mengenali kata-kata umum dan memampatkannya menjadi lebih sedikit token.

Kemungkinan pemecahan token:

- "aku"

- "makan"

- "pi"

- "sang"

Namun karena efisiensinya tinggi, bisa jadi seluruh kata "pisang" dianggap satu token.

Kesimpulan: Model ini lebih hemat token, artinya lebih efisien untuk teks berbahasa Indonesia.

⚖️ GPT-3.5 & GPT-4 (5 tokens)

Tokenizer yang digunakan di sini masih efisien, tetapi sedikit lebih kasar dibanding GPT-4o.

Kemungkinan pemecahan token:

- "aku"

- " " (spasi)

- "makan"

- " " (spasi)

- "pisang"

Bisa juga: - "aku"

- "makan"

- "pi"

- "san"

- "g"

Kesimpulan: Tokenisasi lebih mendetail daripada GPT-4o, tapi masih cukup efisien.

❗ GPT-3 (Legacy) (7 tokens)

Model ini menggunakan tokenizer yang kurang efisien, cenderung memecah kata lebih agresif menjadi beberapa token kecil.

Contoh kemungkinan:

- "a"

- "ku"

- " "

- "ma"

- "kan"

- " "

- "pisang"

Kesimpulan: Jumlah token meningkat, yang berarti lebih boros dan kurang cocok untuk teks bahasa Indonesia modern, karena tokenizer ini lebih dioptimalkan untuk bahasa Inggris dan belum disempurnakan untuk efisiensi lintas bahasa.

? Kesimpulan Umum:

- Jumlah karakter tetap, tapi jumlah token bisa berbeda tergantung model/tokenizer.

- Semakin baru modelnya, semakin efisien dalam mengenali dan mengelompokkan kata menjadi token.

- Dalam konteks penggunaan API (misalnya ChatGPT API), lebih sedikit token = lebih hemat biaya dan ruang input/output.

- GPT-4o sangat cocok untuk penggunaan bahasa Indonesia karena lebih optimal dalam pemecahan token.

Aplikasi penghitung Tokenizer dari Open AI (Chat GPT)

? Analisis Lengkap:

1. Karakter Tetap = 16

Semua model sepakat bahwa kalimat ini memiliki 16 karakter, yang terdiri dari:

-

"aku" = 3 huruf

-

spasi = 1

-

"makan" = 5 huruf

-

spasi = 1

-

"pisang" = 6 huruf

→ Total = 3 + 1 + 5 + 1 + 6 = 16 karakter

2. Perbedaan Jumlah Token

Setiap model menggunakan tokenizer yang berbeda, yaitu cara mereka memecah teks menjadi potongan-potongan kecil (token) untuk diproses.

✅ GPT-4o & GPT-4o mini (4 tokens)

Model ini menggunakan tokenizer yang lebih canggih dan efisien. Ia mampu mengenali kata-kata umum dan memampatkannya menjadi lebih sedikit token.

Kemungkinan pemecahan token:

-

"aku"

-

"makan"

-

"pi"

-

"sang"

Namun karena efisiensinya tinggi, bisa jadi seluruh kata "pisang" dianggap satu token.

Kesimpulan: Model ini lebih hemat token, artinya lebih efisien untuk teks berbahasa Indonesia.

⚖️ GPT-3.5 & GPT-4 (5 tokens)

Tokenizer yang digunakan di sini masih efisien, tetapi sedikit lebih kasar dibanding GPT-4o.

Kemungkinan pemecahan token:

-

"aku"

-

" " (spasi)

-

"makan"

-

" " (spasi)

-

"pisang"

Bisa juga: -

"aku"

-

"makan"

-

"pi"

-

"san"

-

"g"

Kesimpulan: Tokenisasi lebih mendetail daripada GPT-4o, tapi masih cukup efisien.

❗ GPT-3 (Legacy) (7 tokens)

Model ini menggunakan tokenizer yang kurang efisien, cenderung memecah kata lebih agresif menjadi beberapa token kecil.

Contoh kemungkinan:

-

"a"

-

"ku"

-

" "

-

"ma"

-

"kan"

-

" "

-

"pisang"

Kesimpulan: Jumlah token meningkat, yang berarti lebih boros dan kurang cocok untuk teks bahasa Indonesia modern, karena tokenizer ini lebih dioptimalkan untuk bahasa Inggris dan belum disempurnakan untuk efisiensi lintas bahasa.

? Kesimpulan Umum:

-

Jumlah karakter tetap, tapi jumlah token bisa berbeda tergantung model/tokenizer.

-

Semakin baru modelnya, semakin efisien dalam mengenali dan mengelompokkan kata menjadi token.

-

Dalam konteks penggunaan API (misalnya ChatGPT API), lebih sedikit token = lebih hemat biaya dan ruang input/output.

-

GPT-4o sangat cocok untuk penggunaan bahasa Indonesia karena lebih optimal dalam pemecahan token.